猛,实在是猛!就在今日,老牌芯片巨头amd交出了一份令人印象深刻的ai答卷。

智东西美国旧金山10月10日现场报道,酷热的天气刚刚过去,旧金山正值秋意凉爽,今日举行的amd advancing ai 2024盛会却格外火热。

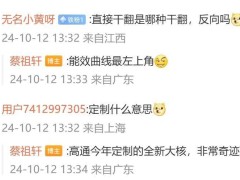

amd倾囊倒出了一系列ai杀手锏,发布全新旗舰ai芯片、服务器cpu、ai网卡、dpu和ai pc移动处理器,将ai计算的战火烧得更旺。

这家芯片巨头还大秀ai朋友圈,现场演讲集齐了谷歌、openai、微软、meta、xai、cohere、rekaai等重量级ai生态伙伴。

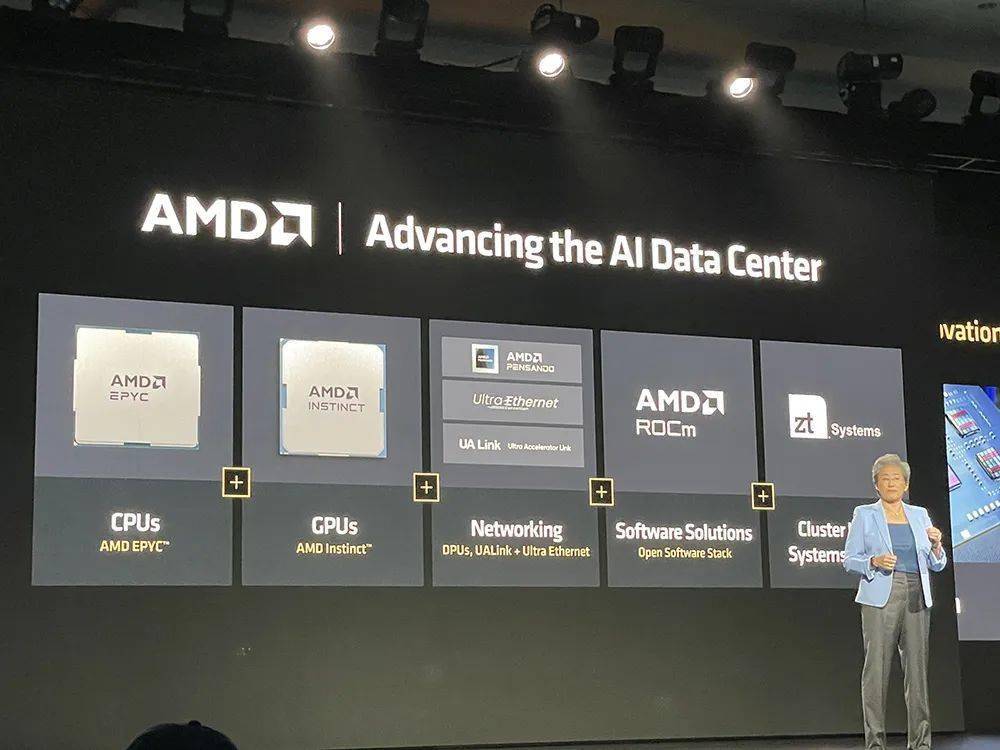

备受期待的旗舰ai芯片amd instinct mi325x gpu首次启用hbm3e高带宽内存,8卡ai峰值算力达到21pflops,并与去年发布的、同样采用hbm3e的英伟达h200 gpu用数据掰手腕:内存容量是h200的1.8倍,内存带宽、fp16和fp8峰值理论算力都是h200的1.3倍。

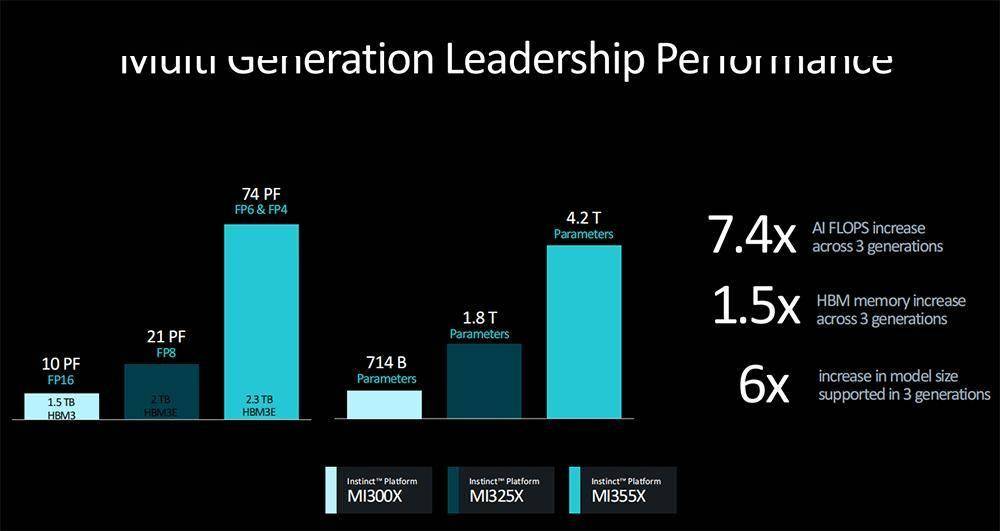

amd还披露了最新的ai芯片路线图,采用cdna 4架构的mi350系列明年上市,其中8卡mi355x的ai峰值算力达到74pflops,mi400系列将采用更先进的cdna架构。

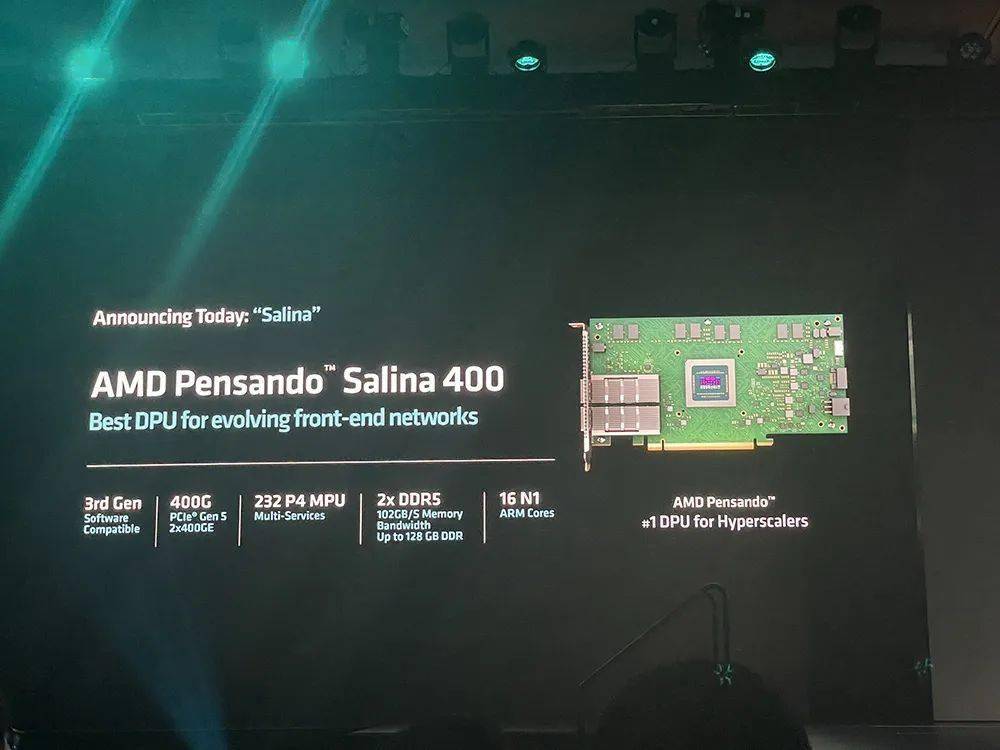

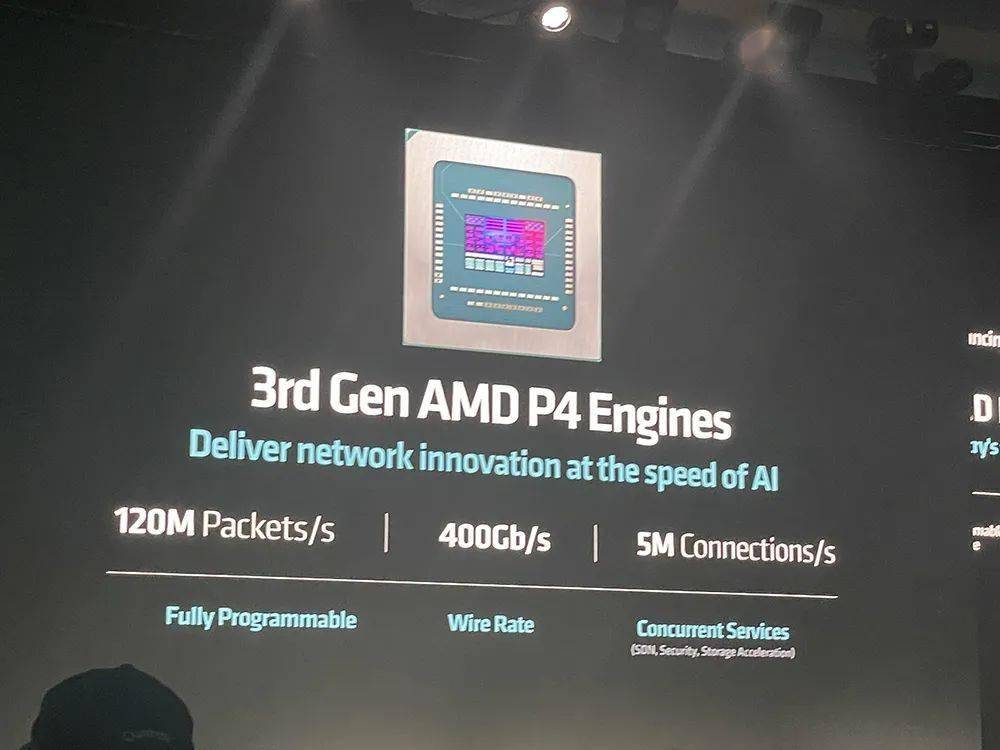

更高的数据中心算力,离不开先进的网络凯发app平台的解决方案。对此,amd发布了业界首款支持uec超以太网联盟的ai网卡pensando pollara 400和性能翻倍提升的pensando salina 400 dpu。

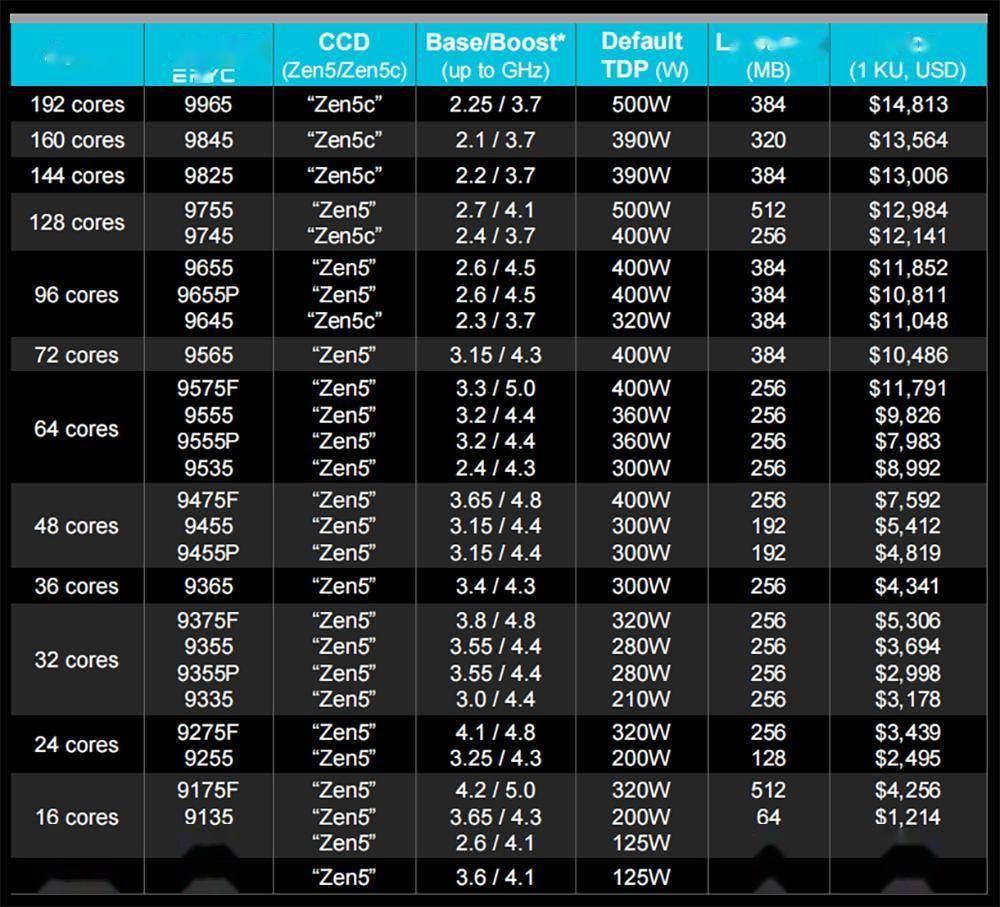

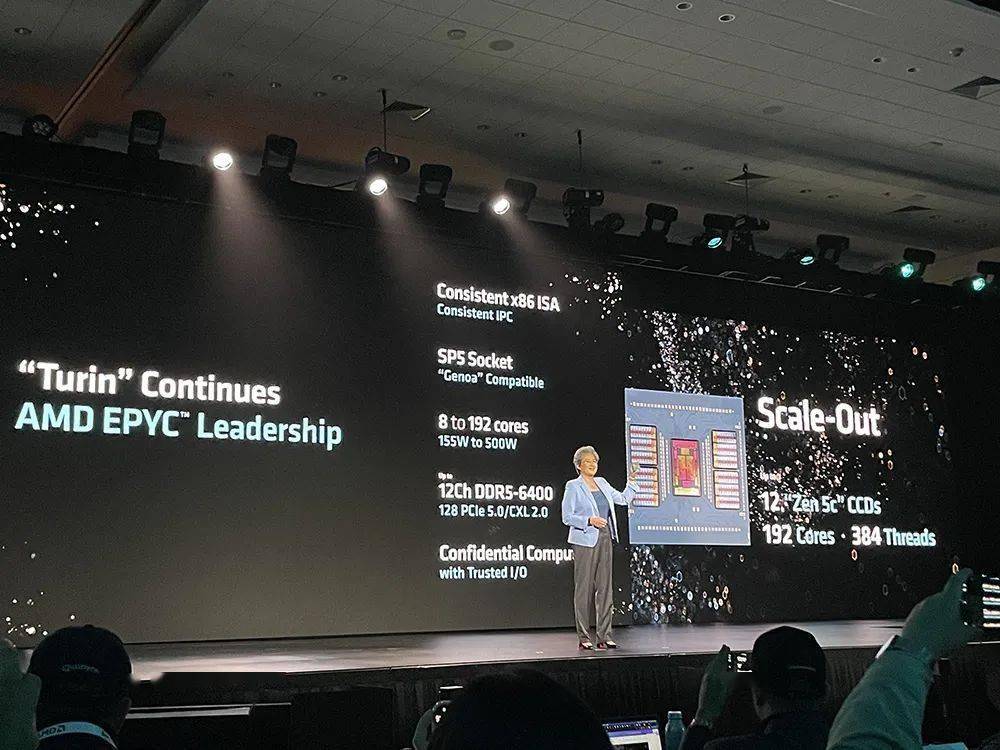

另一款重磅新品是第五代epyc服务器cpu,被amd称为“面向云计算、企业级和ai的全球最好cpu”,采用台积电3/4nm制程工艺,最多支持192核、384个线程。其中顶配epyc 9965默认热设计功耗500w,以1000颗起订的单价为14813美元(约合人民币10万元)。

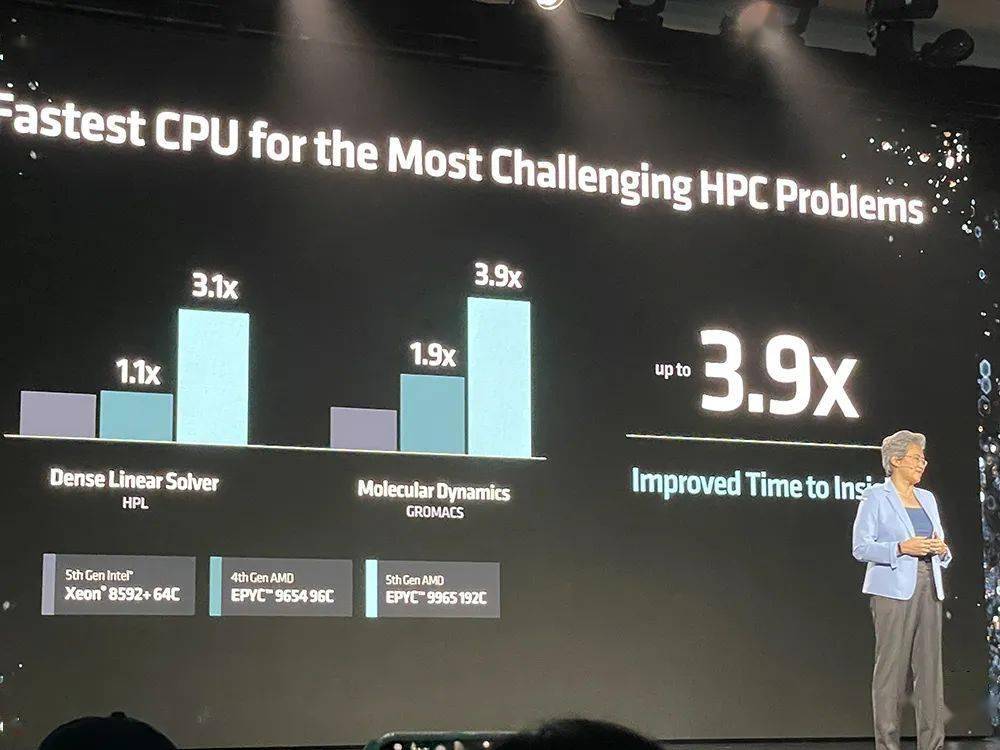

与第五代英特尔至强铂金8592 处理器相比,amd epyc 9575f处理器的spec cpu性能提高多达2.7倍,企业级性能提高多达4.0倍,hpc(高性能计算)性能提高多达3.9倍,基于cpu的ai加速提高多达3.8倍,gpu主机节点提升多达1.2倍。

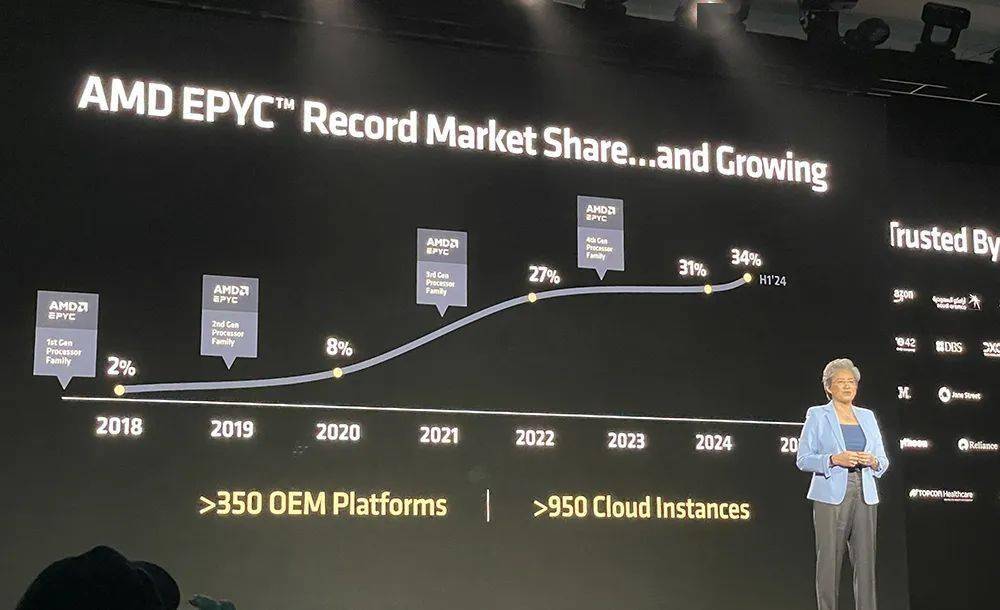

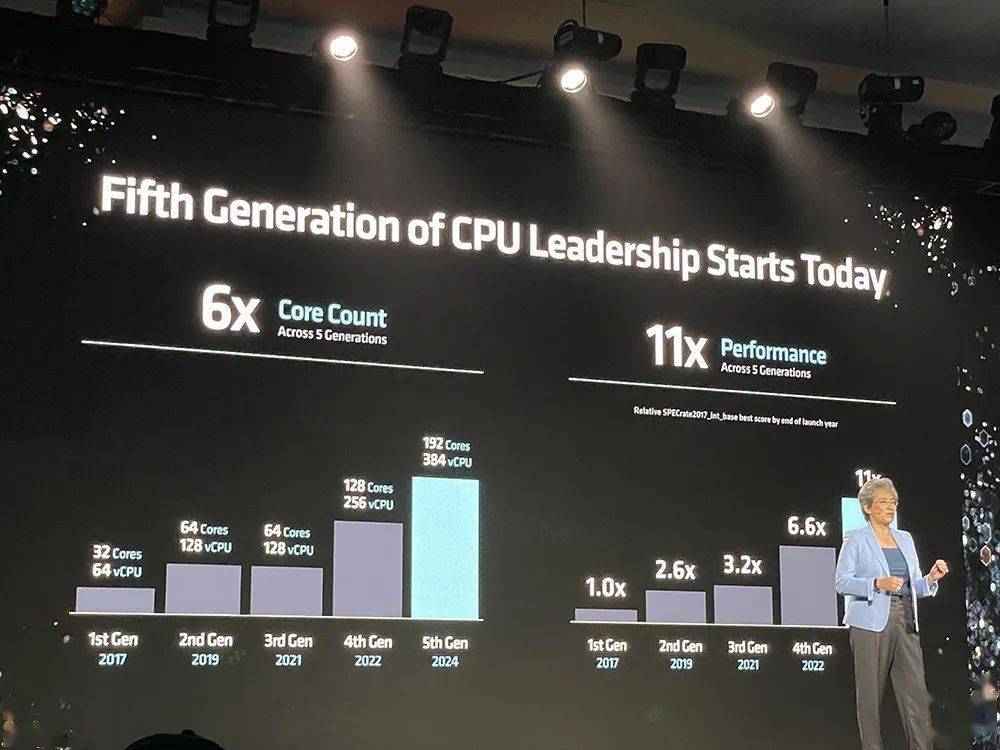

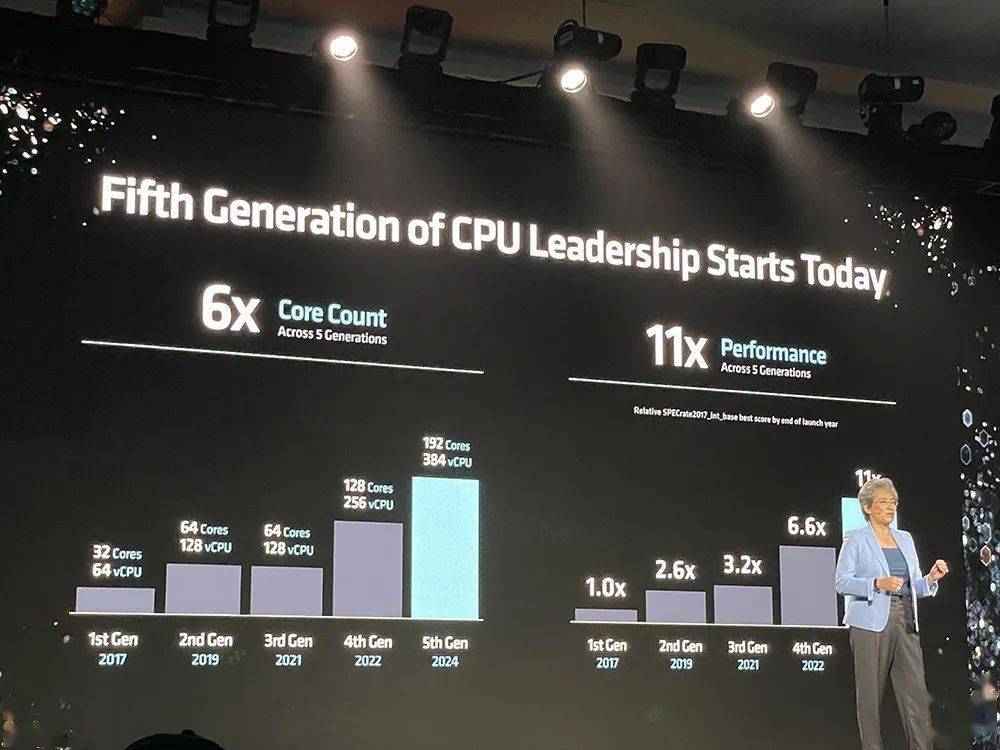

自2017年重回数据中心市场后,amd一路势头强劲:其数据中心cpu收入市占率在2018年还只有2%,今年上半年已攀爬到34%,在全球覆盖超过950个云实例和超过350个oxm平台。

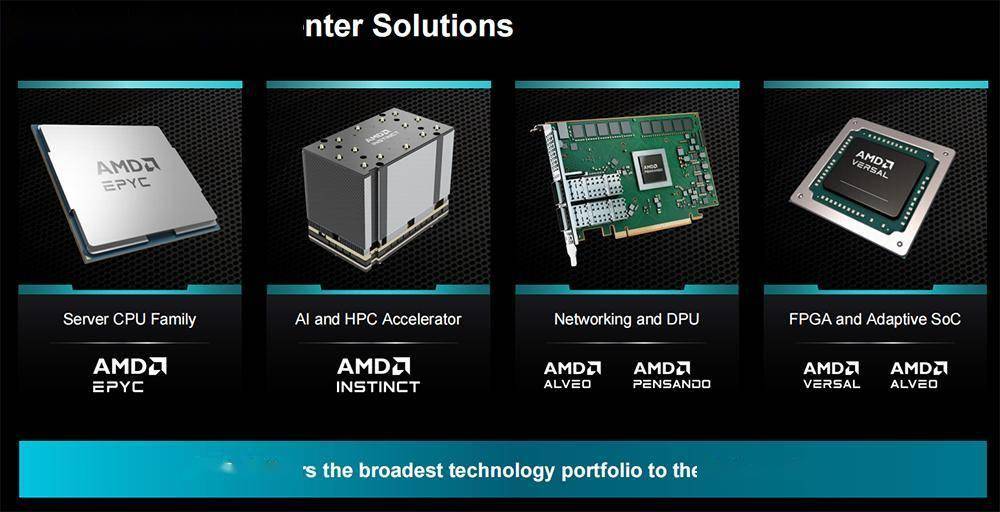

amd是唯一一家能够提供全套cpu、gpu和网络凯发app平台的解决方案来满足现代数据中心所有需求的公司。

ai pc芯片也迎来了新成员——amd第三代商用ai移动处理器锐龙ai pro 300系列。它被amd称作“为下一代企业级ai pc打造的全球最好处理器”,预计到2025年将有超过100款锐龙ai pro pc上市。

01.

旗舰ai芯片三代同堂:

内存容量带宽暴涨,峰值算力冲9.2pf

ai芯片,正成为amd业务增长的重头戏。

amd去年12月发布的instinct mi300x加速器,已经成为amd历史上增长最快的产品,不到两个季度销售额就超过了10亿美元。

今年6月,amd公布全新年度ai gpu路线图,最新一步便是今日发布的instinct mi325x。在7月公布季度财报时,amd董事会主席兼ceo苏姿丰博士透露,amd预计其今年数据中心gpu收入将超过45亿美元。

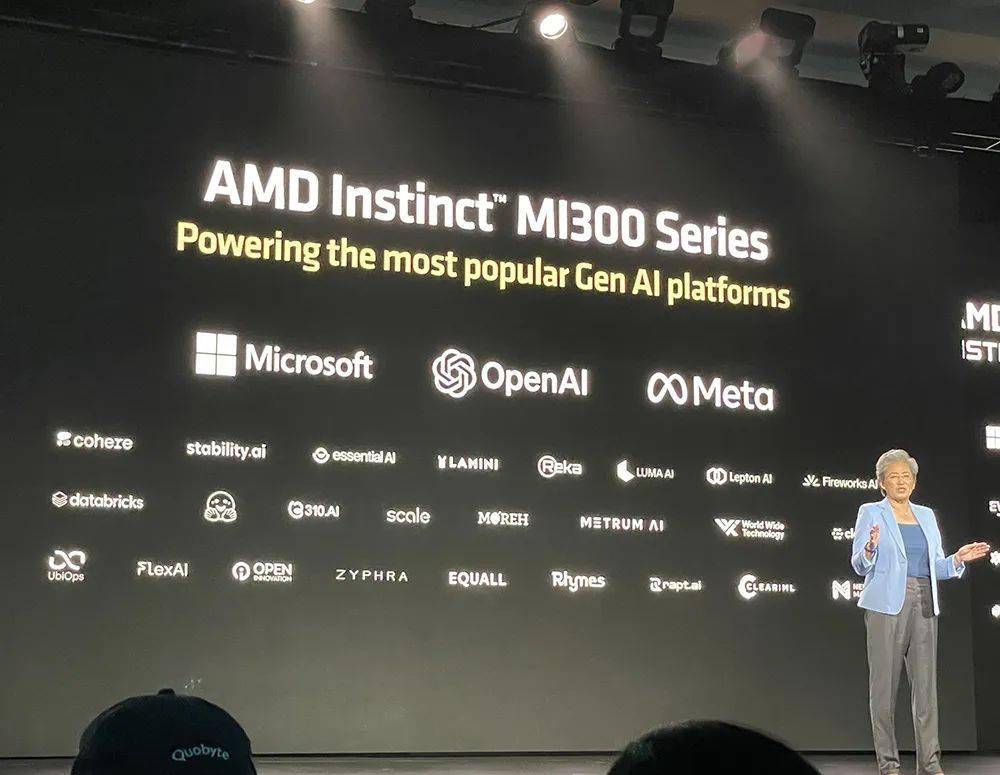

微软、openai、meta、cohere、stability ai、lepton ai(贾扬清创办)、world labs(李飞飞创办)等公司的很多主流生成式ai凯发app平台的解决方案均已采用mi300系列ai芯片。

微软董事长兼ceo萨提亚·纳德拉对mi300赞誉有加,称这款ai加速器在微软azure工作负载的gpt-4推理上提供了领先的价格/性能。

基于llama 3.1 405b运行对话式ai、内容生成、ai agent及聊天机器人、总结摘要等任务时,mi300的推理速度最多达到英伟达h100的1.3倍。

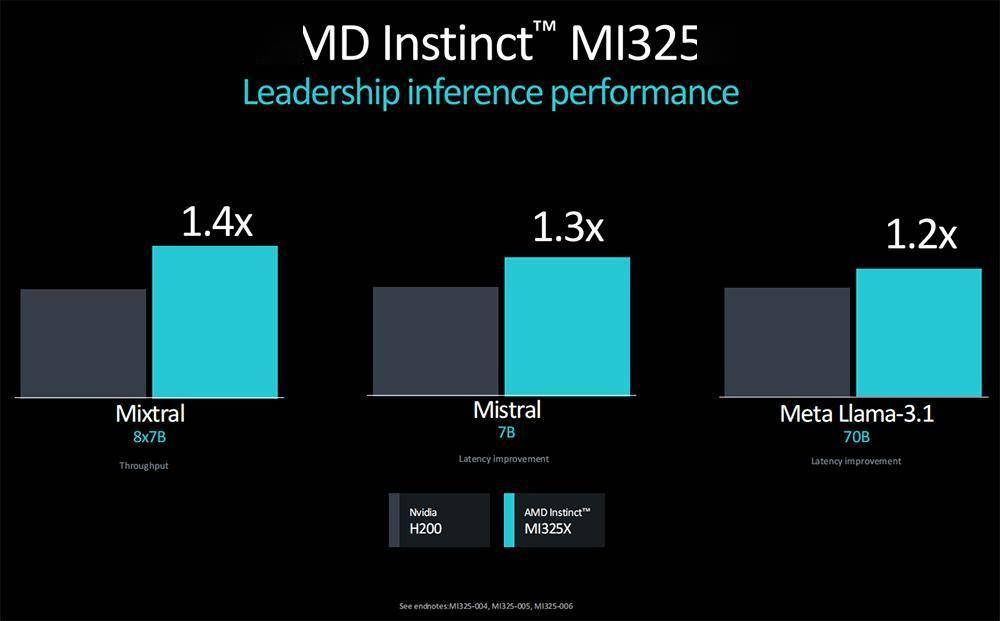

新推出的mi325x进一步抬高性能,跑mixtral 8x7b、mistral 7b、llama 3.1 70b等大模型的推理性能,比英伟达h200快20%~40%。

mi325x拥有1530亿颗晶体管,采用cdna 3架构、256gb hbm3e内存,内存带宽达6tb/s,fp8峰值性能达到2.6pflops,fp16峰值性能达到1.3pflops。

由8张mi325x组成的服务器平台有2tb hbm3e内存;内存带宽达到48tb/s;infinity fabric总线带宽为896gb/s;fp8性能最高达20.8pflops,fp16性能最高达10.4pflops。

相比英伟达h200 hgx,mi325x服务器平台在跑llama 3.1 405b时,推理性能可提高40%。

从训练性能来看,单张mi325x训练llama 2 7b的速度超过单张h200,8张mi325x训练llama 2 70b的性能比肩h200 hgx。

amd instinct mi325x加速器或将于今年第四季度投产,将从明年第一季度起为平台供应商提供。

下一代mi350系列采用3nm制程工艺、新一代cdna 4架构、288gb hbm3e内存,新增对fp4/fp6数据类型的支持,推理性能相比基于cdna 3的加速器有高达35倍的提升,有望在2025年下半年上市。

mi355x加速器的fp8和fp16性能相比mi325x提升了80%,fp16峰值性能达到2.3pflops,fp8峰值性能达到4.6pflops,fp6和fp4峰值性能达到9.2pflops。

8张mi355x共有2.3tb hbm3e内存,内存带宽达到64tb/s,fp16峰值性能达到18.5pflops,fp8峰值性能达到37pflops,新增fp6和fp4的峰值性能为74pflops。

三代gpu的配置显著升级:相比8卡mi300x,8卡mi355x的ai峰值算力提升多达7.4倍、hbm内存提高多达1.5倍、支持的模型参数量提升幅度接近6倍。

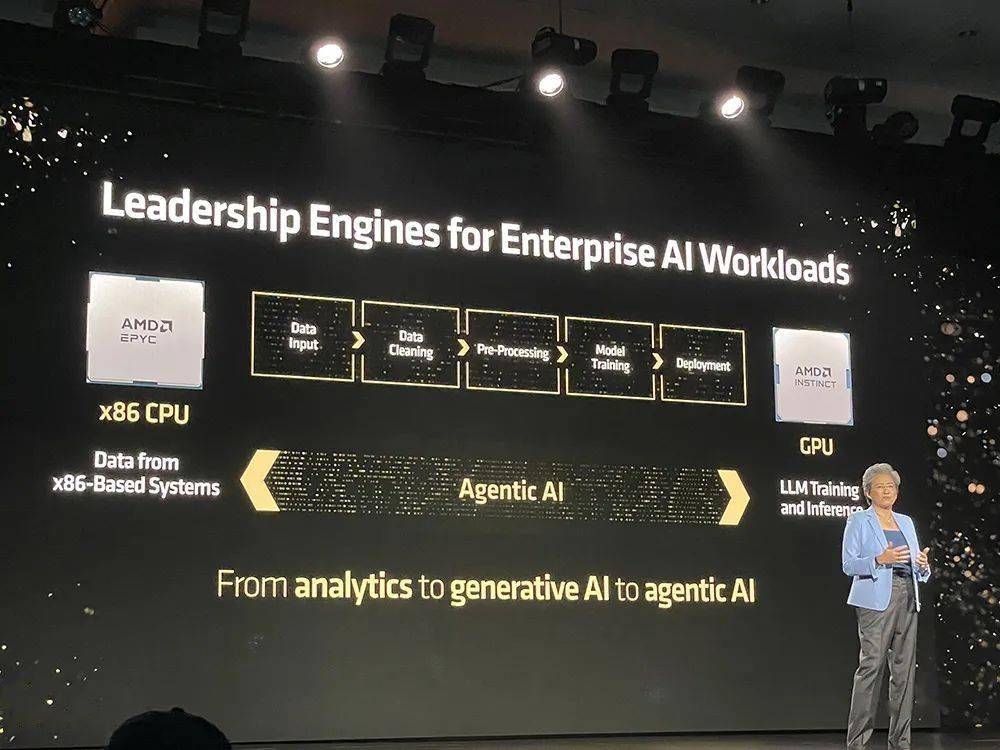

amd持续投资软件和开放生态系统,在amd rocm开放软件栈中提供新特性和功能,可原生支持主流ai框架及工具,具备开箱即用特性,搭配amd instinct加速器支持主流生成式ai模型及hugging face上的超过100万款模型。

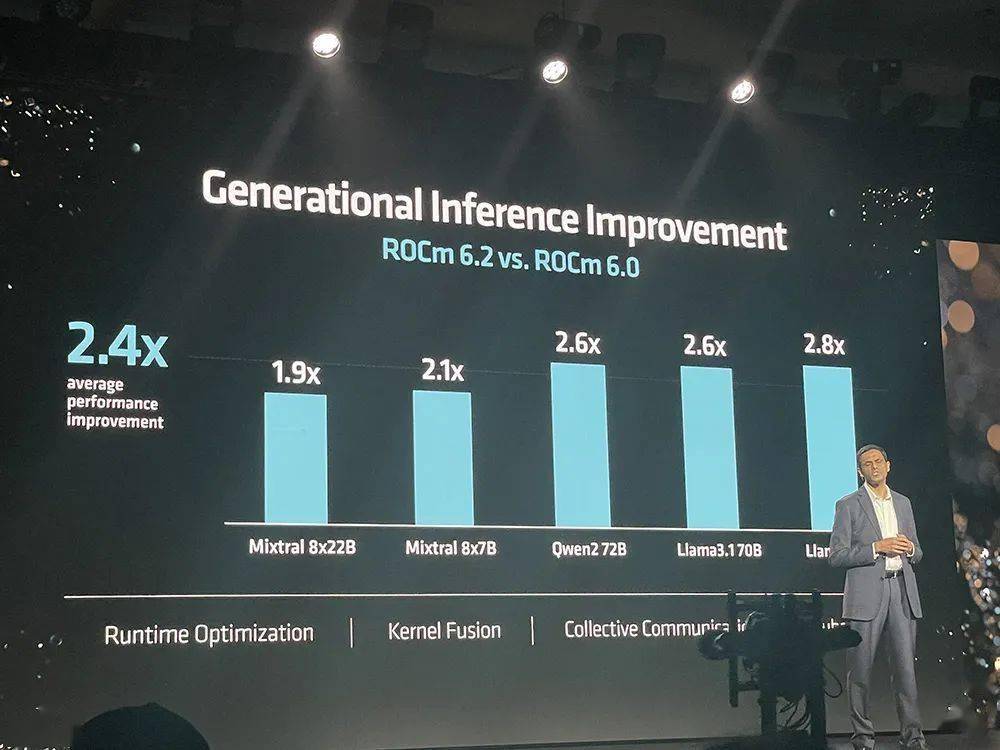

rocm 6.2现包括对关键ai功能的支持,如fp8数据类型、flash attention、内核融合等,可将ai大模型的推理性能、训练性能分别提升至rocm 6.0的2.4倍、1.8倍。

此前amd收购了欧洲最大的私人ai实验室silo ai,以解决消费级ai最后一英里问题,加快amd硬件上ai模型的开发和部署。欧洲最快的超级计算机lumi便采用amd instinct加速器来训练欧洲语言版的大语言模型。

02.

下一代ai网络:后端引入业界首款支持uec的ai网卡,前端上新400g可编程dpu

网络是实现最佳系统性能的基础。ai模型平均有30%的训练周期时间都花在网络等待上。在训练和分布式推理模型中,通信占了40%-75%的时间。

ai网络分为前端和后端:前端向ai集群提供数据和信息,可编程dpu不断发展;后端管理加速器与集群间的数据传输,关键在于获得最大利用率。

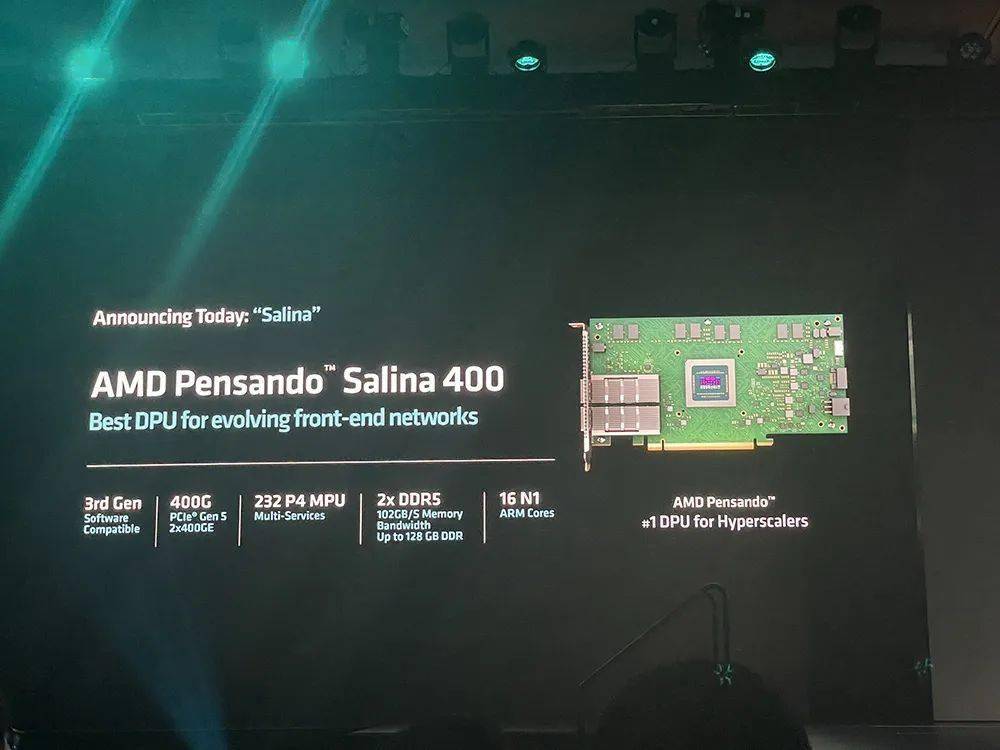

为了有效管理这两个网络,并推动整个系统的性能、可扩展性和效率提升,amd今日发布了应用于前端网络的pensando salina 400 dpu和应用于后端网络的pensando pollara 400网卡。

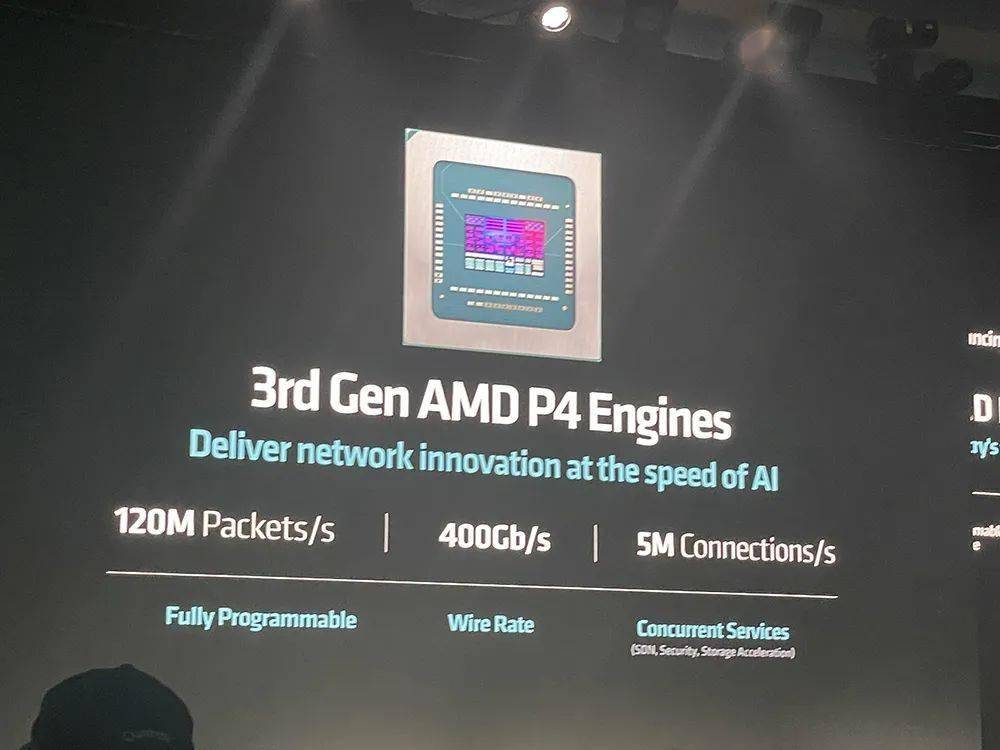

salina 400是amd第三代可编程dpu,被amd称作“前端网络最佳dpu”,其性能、带宽和规模均提高至上一代dpu的两倍;pollara 400是业界首款支持超以太网联盟(uec)的ai网卡。

salina 400支持400g吞吐量,可实现快速数据传输速率,可为数据驱动的ai应用优化性能、效率、安全性和可扩展性。

pollara 400 采用 amd p4可编程引擎,支持下一代rdma软件,并以开放的网络生态系统为后盾,对于在后端网络中提供加速器到加速器通信的领先性能、可扩展性和效率至关重要。

uec ready rdma支持智能数据包喷发和有序消息传递、避免拥塞、选择性重传和快速损失恢复。这种传输方式的消息完成速度是rocev2的6倍,整体完成速度是rocev2的5倍。

在后端网络,相比infiniband,以太网rocev2是更好的选择,具有低成本、高度可扩展的优势,可将tco节省超过50%,能够扩展100万张gpu。而infiniband至多能扩展48000张gpu。

03.

服务器cpu:

3/4nm制程,最多192核/384线程

今年7月公布财报时,苏姿丰提到今年上半年,有超过1/3的企业服务器订单来自首次在其数据中心部署epyc服务器cpu的企业。

第五代epyc处理器9005系列(代号“turin”)专为现代数据中心设计。

该处理器在计算、内存、io与平台、安全四大层面全面升级。

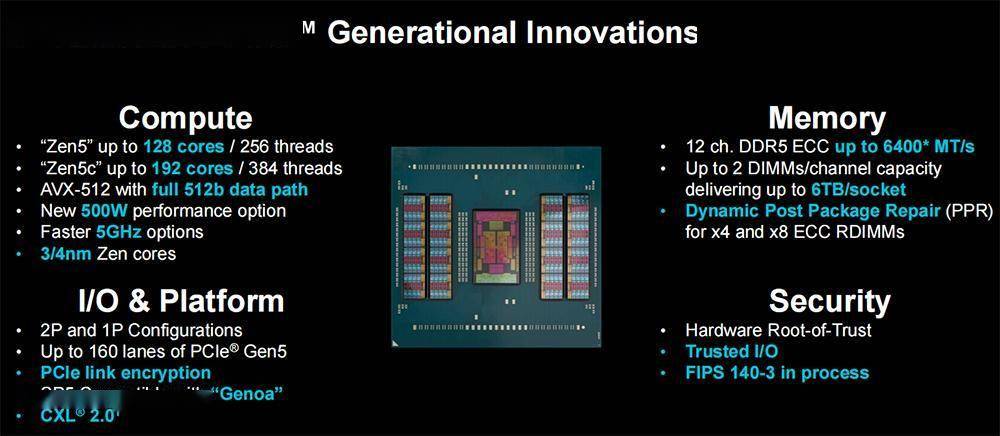

第五代epyc拥有1500亿颗晶体管,采用台积电3/4nm 制程、全新“zen 5”及“zen 5c”核心兼容广泛部署的sp5平台,最多支持192核、384个线程,8~192核的功耗范畴为155w~500w。

它支持avx-512全宽512位数据路径、128 pcie 5.0/cxl 2.0、ddr5-6400mt/s内存速率,提升频率高达5ghz,机密计算的可信i/o和fips认证正在进行中。

与“zen 4”相比,“zen 5”核心架构为企业和云计算工作负载提供了提升17%的ipc(每时钟指令数),为ai和hpc提供了提升37%的ipc。

在spec cpu 2017基准测试中,192核epyc 9965的整数吞吐量是64核至强8592 的2.7倍,32核epyc 9355的每核心性能是32核6548y 的1.4倍。

跑视频转码、商用app、开源数据库、图像渲染等商用工作负载时,192核epyc 9965的性能达到64核至强8592 性能的3~4倍。

在处理开源的hpc密集线性求解器、建模和仿真任务时,epyc 9965的性能可达到至强8592 性能的2.1~3.9倍。

达到相同性能,第五代epyc所需的服务器数量更少,有助于降低数据中心的tco(总拥有成本)以及节省空间和能源。

例如,要达到总共391000个单位的specrate 2017_int_base性能得分,相比1000台搭载英特尔至强铂金8280的服务器,现在131台搭载amd epyc 9965的现代服务器就能实现,功耗、3年tco均显著减少。

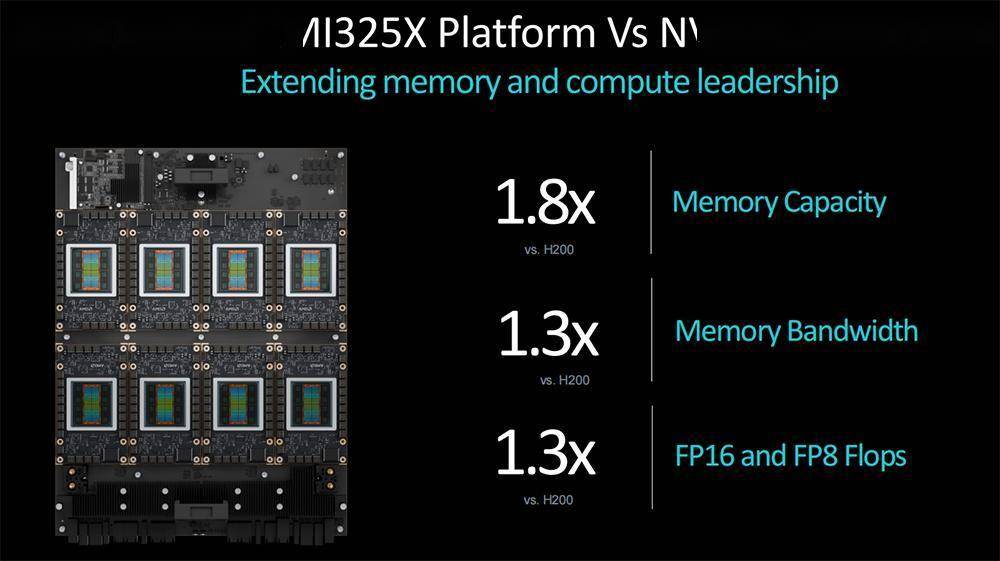

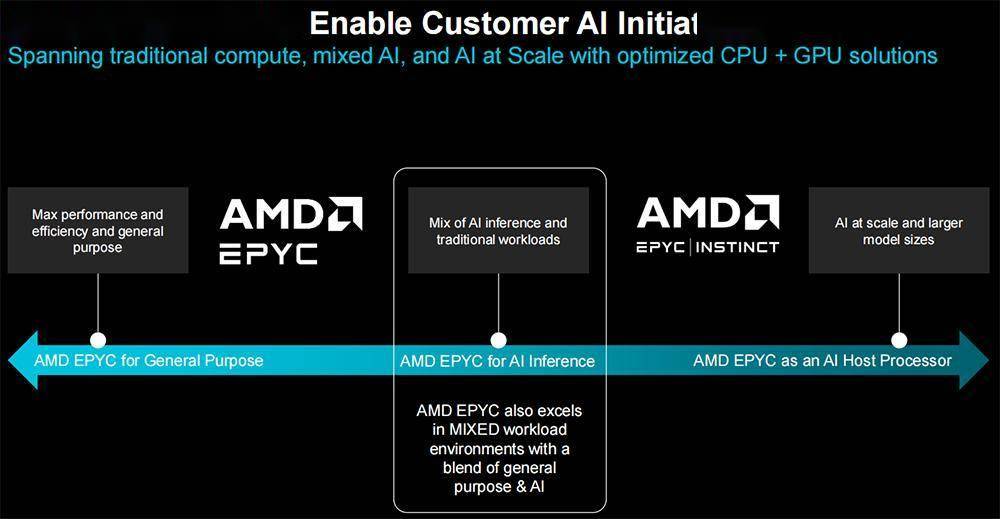

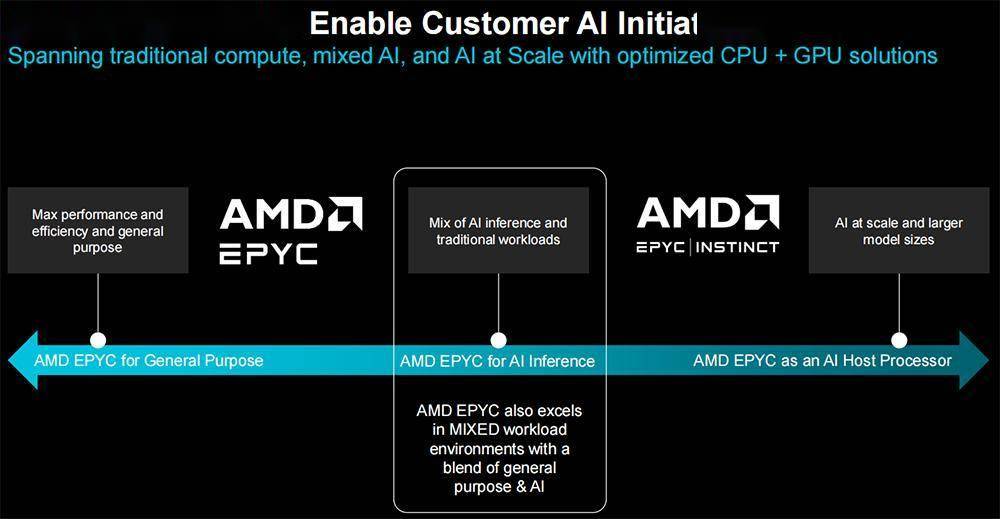

通过优化的cpu gpu凯发app平台的解决方案,amd epyc cpu不仅能处理传统通用目的的计算,而且能胜任ai推理,还能作为ai主机处理器。

相比64核至强8592 ,192核epyc 9965在运行机器学习、端到端ai、相似搜索、大语言模型等工作负载时,推理性能提升多达1.9~3.8倍。

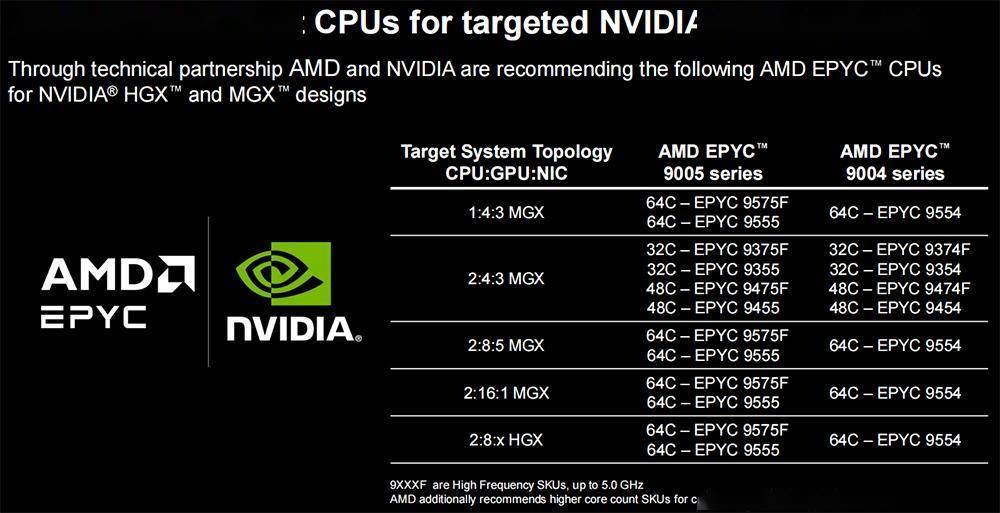

amd epyc 9005系列的新产品是64核epyc 9575f,专为需要终极主机cpu能力的gpu驱动ai凯发app平台的解决方案量身定制。

与竞争对手的3.8ghz处理器相比,专用ai主机的cpu epyc 9575f提供了高达5ghz的提升,可将gpu编排任务的处理速度提高28%。

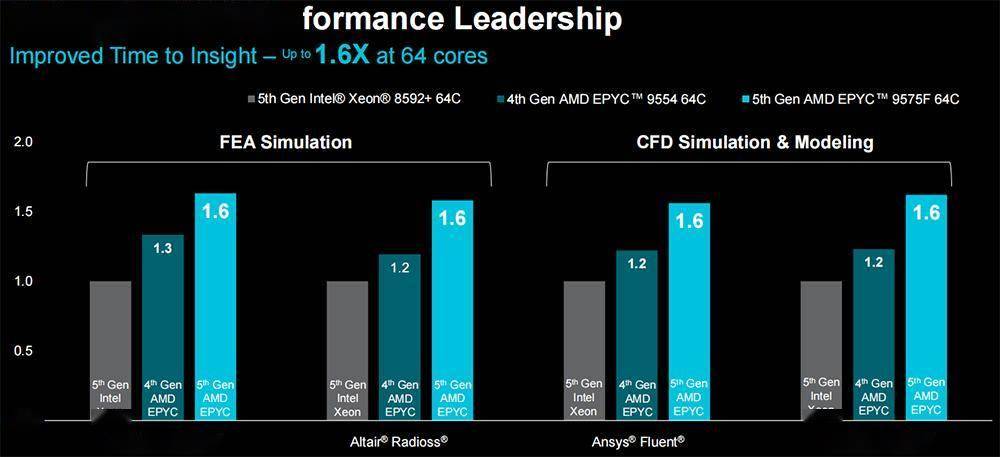

面向企业级hpc工作负载,64核epyc 9575f的fea仿真和cfd仿真&建模的性能,可提升至64核至强8592的1.6倍。

epyc 9575f可使用其5ghz的最大频率提升来助力1000个节点的ai集群每秒驱动多达70万个推理token。同样搭配mi300x gpu,与64核至强8592 相比,epyc 9575f将gpu系统训练stable diffusion xl v2文生图模型的性能提升20%。

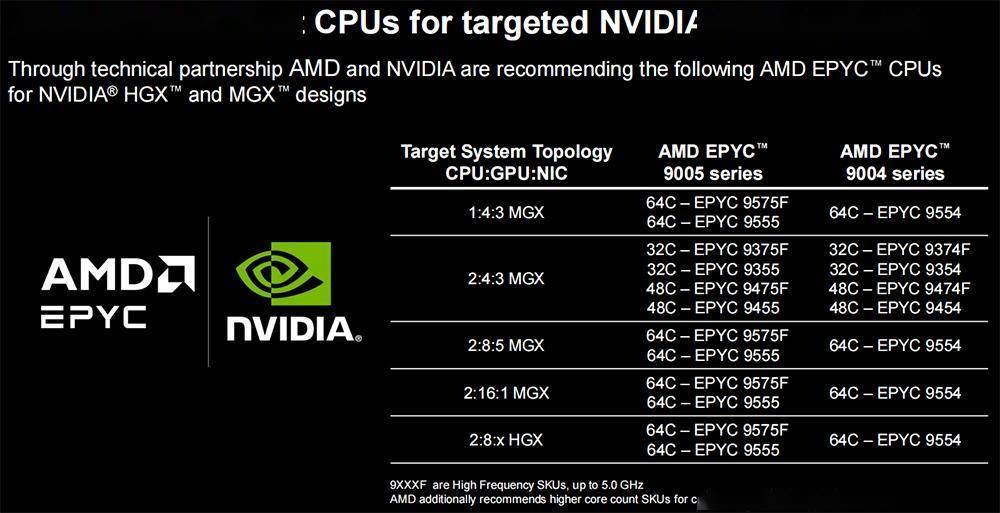

搭配instinct系列gpu的amd epyc ai主机cpu型号如下:

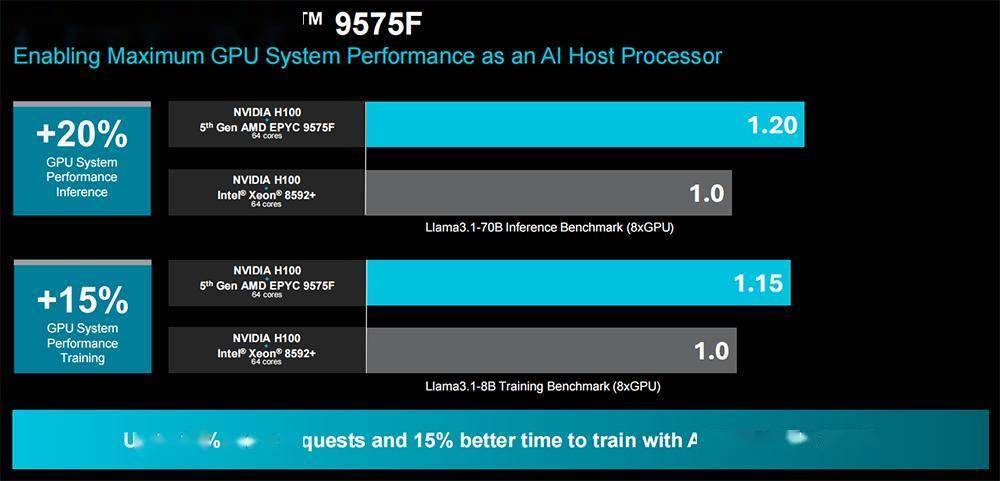

同样搭配英伟达h100,epyc 9575f可将gpu系统的推理性能、训练性能分别相比至强8592 提升20%、15%。

与英伟达gpu系统适配的amd epyc ai主机cpu型号如下:

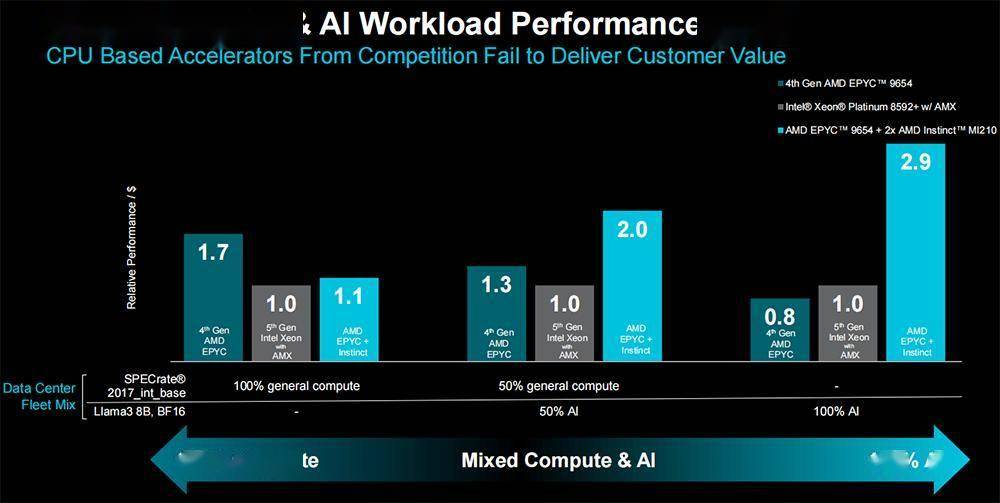

将epyc用于计算与ai混合工作负载时,相比至强铂金8592 ,epyc 9654 2张instinct mi210在处理50%通用计算 50% ai的混合任务时,每美元性能可提升多达2倍。

04.

企业级ai pc处理器:

升级“zen 5”架构,ai算力最高55tops

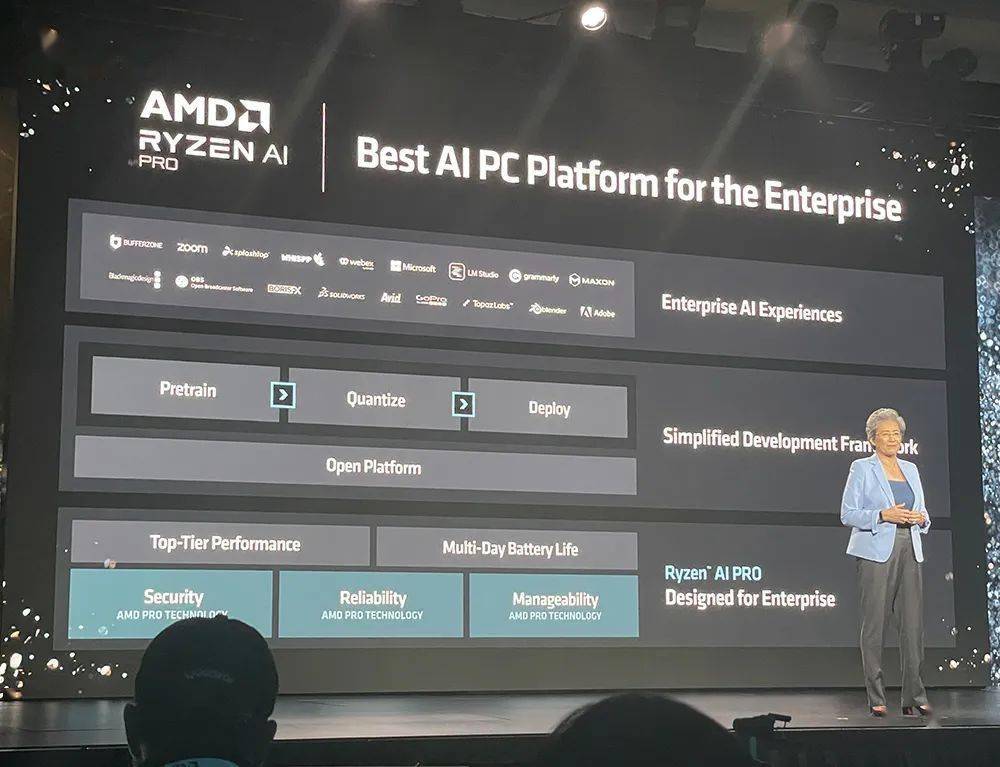

ai pc给企业生产力、身临其境的远程协作、创作与编辑、个人ai助理都带来了全新转型体验。

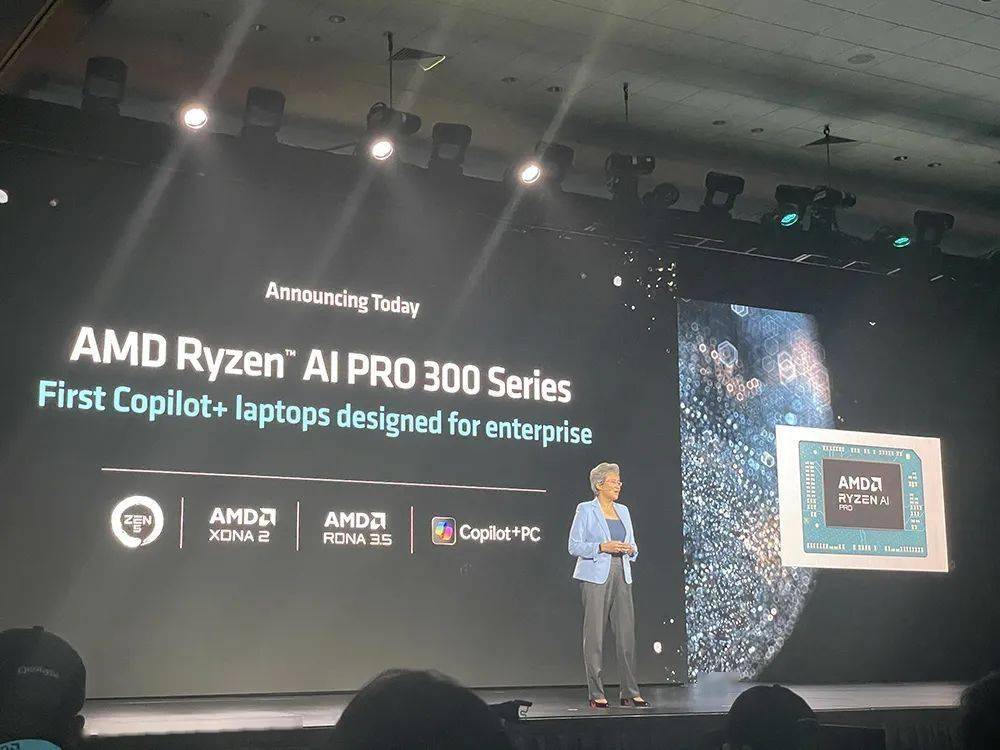

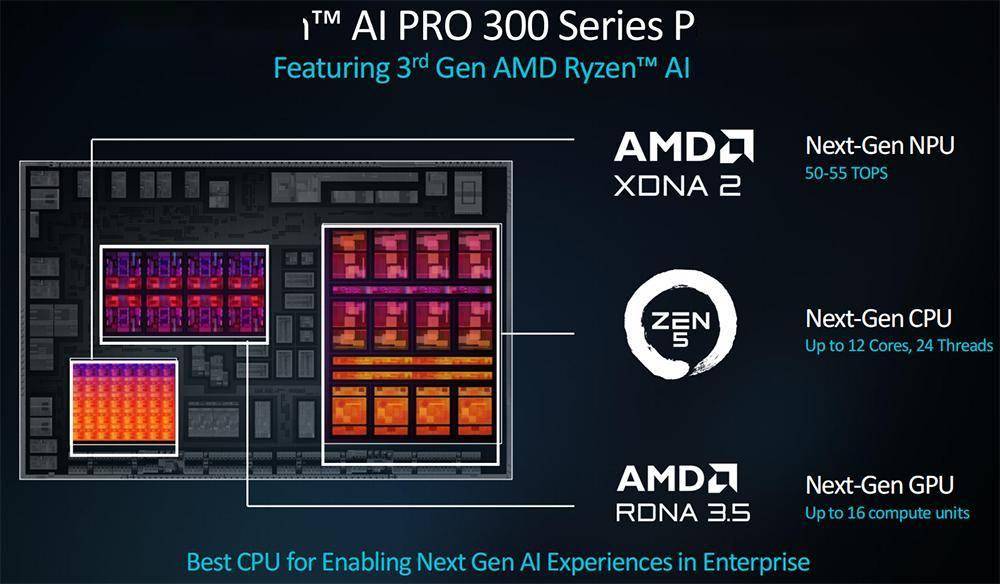

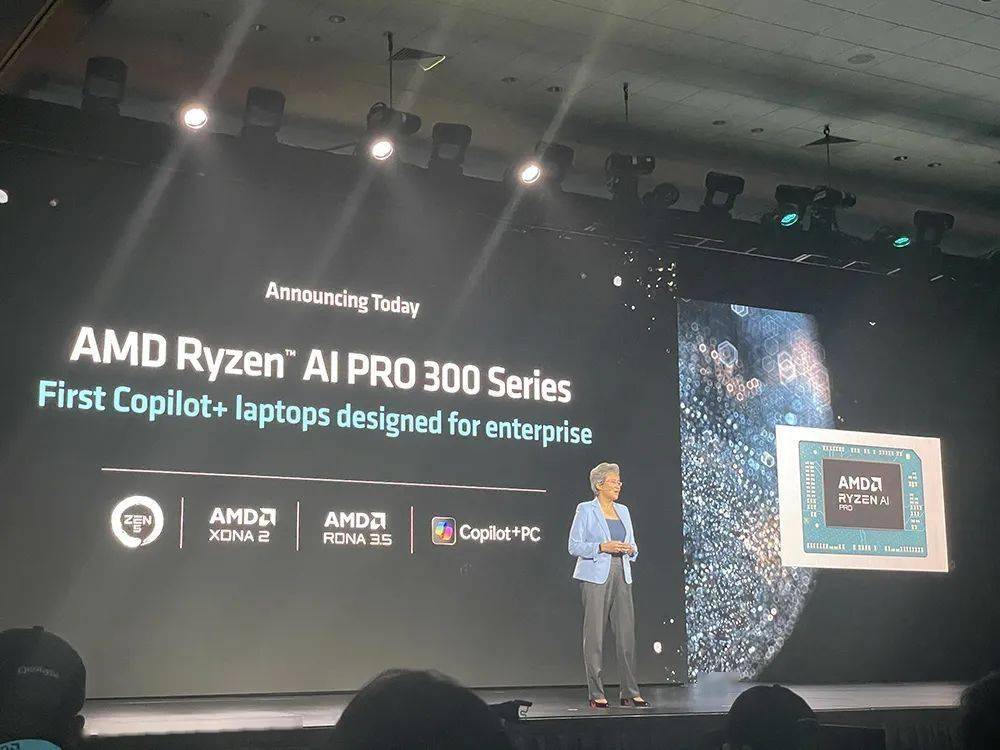

继今年6月推出第三代ai移动处理器锐龙ai 300系列处理器(代号“strix point”)后,今日amd宣布推出锐龙ai pro 300系列。

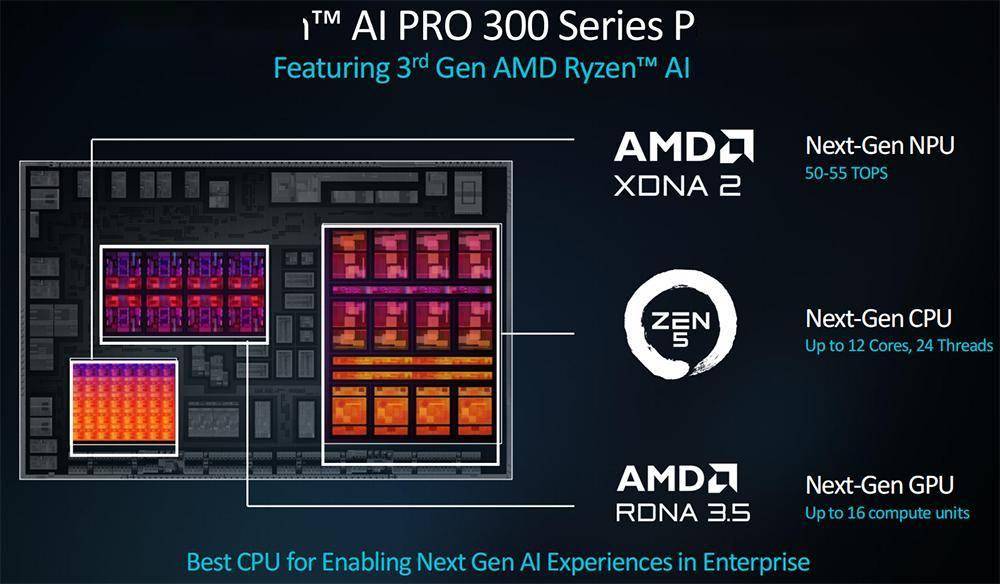

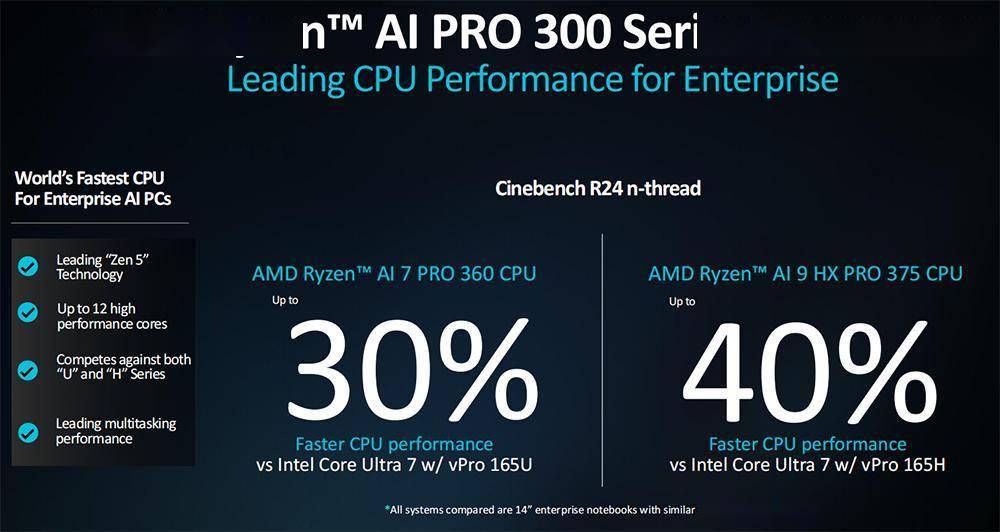

该处理器专为提高企业生产力而设计,采用4nm工艺、“zen 5”cpu架构(最多12核、24个线程)、rdna 3.5gpu架构(最多16个计算单元),支持copilot 功能,包括电话会议实时字幕、语言翻译、ai图像生成等。

其内置npu可提供50-55tops的ai处理能力。

40tops是微软copilot ai pc的基准要求。相比之下,苹果m4、amd锐龙pro 8040系列、英特尔酷睿ultra 100系列的npu算力分别为38tops、16tops、11tops。

与英特尔酷睿ultra 7 165h相比,旗舰锐龙ai 9 hx pro 375的多线程性能提高了40%,办公生产力提高了14%,支持更长续航。

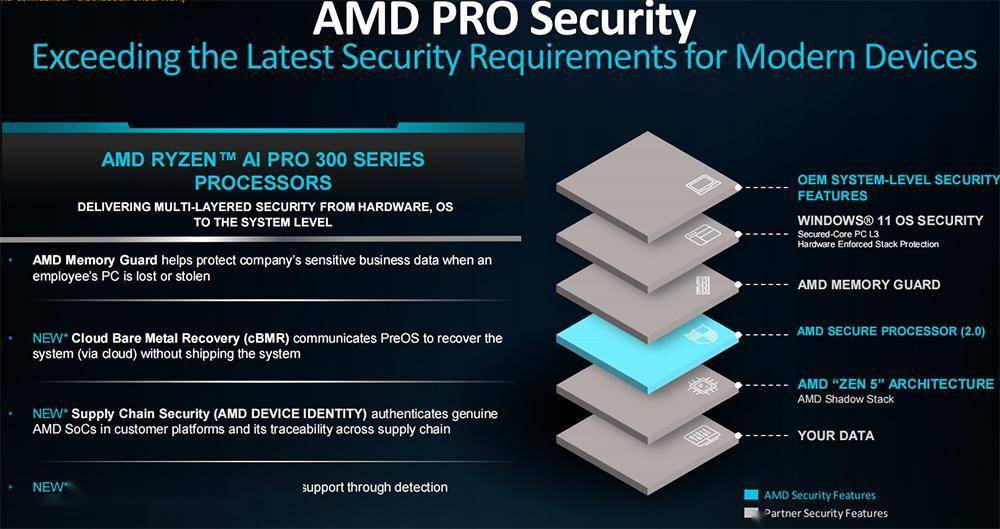

锐龙ai pro 300系列采用amd pro技术,提供世界级领先的安全性和可管理性,旨在简化it运营及部署并确保企业获得卓越的投资回报率。

由搭载锐龙ai pro 300系列的oem系统预计将于今年晚些时候上市。

amd也扩展了其pro技术阵容,具有新的安全性和可管理性功能。配备amd pro技术的移动商用处理器现有云裸机恢复的标准配置,支持it团队通过云无缝恢复系统,确保平稳和持续的操作;提供一个新的供应链安全功能,实现整个供应链的可追溯性;看门狗定时器,提供额外的检测和恢复过程,为系统提供弹性支持。

通过amd pro技术,还能实现额外的基于ai的恶意软件检测。这些全新的安全特性利用集成的npu来运行基于ai的安全工作负载,不会影响日常性能。

05.

结语:amd正在数据中心市场攻势凶猛

amd正沿着路线图,加速将ai基础设施所需的各种高性能ai凯发app平台的解决方案推向市场,并不断证明它能够提供满足数据中心需求的多元化凯发app平台的解决方案。

ai已经成为amd战略布局的焦点。今日新发布的instinct加速器、epyc服务器cpu、pensando网卡&dpu、锐龙ai pro 300系列处理器,与持续增长的开放软件生态系统形成了组合拳,有望进一步增强amd在ai基础设施竞赛中的综合竞争力。

无论是蚕食服务器cpu市场,还是新款ai芯片半年揽金逾10亿美元,都展现出这家老牌芯片巨头在数据中心领域的冲劲。紧锣密鼓的ai芯片产品迭代、快速扩张的全栈软硬件版图,都令人愈发期待amd在ai计算市场创造出惊喜。

本文来自微信公众号“智东西”,作者:zer0,36氪经授权发布。